因為專業

所以領先

過去,大多數芯片都包含一到兩項前沿技術,主要是為了跟上每隔幾年每個新工藝節點的光刻技術的預期改進。這些改進是基于行業路線圖,該路線圖要求隨著時間的推移取得可預測但不顯著的收益。現在,隨著大型語言模型和更多傳感器推動的數據爆炸式增長,以及設計自己芯片的系統公司之間的競爭加劇,以及涉及人工智能的國際競爭日益激烈,芯片設計前沿的規則正在發生相當大的變化。

現在,漸進式改進與處理性能的巨大飛躍相結合,雖然這些改進使計算能力和分析達到了一個全新的水平,但它們也需要一套全新的權衡。

這些轉變的核心是高度定制的芯片架構,其中一些涉及在最先進的工藝節點開發的小芯片。并行處理幾乎是必然的,針對特定數據類型和操作的加速器也是如此。在某些情況下,這些微型系統不會進行商業銷售,因為它們為數據中心提供了競爭優勢。但它們也可能包括其他商用技術,例如處理核心或加速器或用于減少延遲的內存內或近內存計算技術,以及不同的緩存方案、共同封裝的光學器件和更快的互連。其中許多進展多年來一直處于研究或擱置狀態,現在正在全面部署。

谷歌研究院工程研究員兼機器學習系統副總裁 Amin Vahdat 在最近的 Hot Chips 2023 會議上的演講中指出,今天的芯片可以解決十年前無法想象的問題,而機器學習將承擔計算周期“越來越多的任務”。

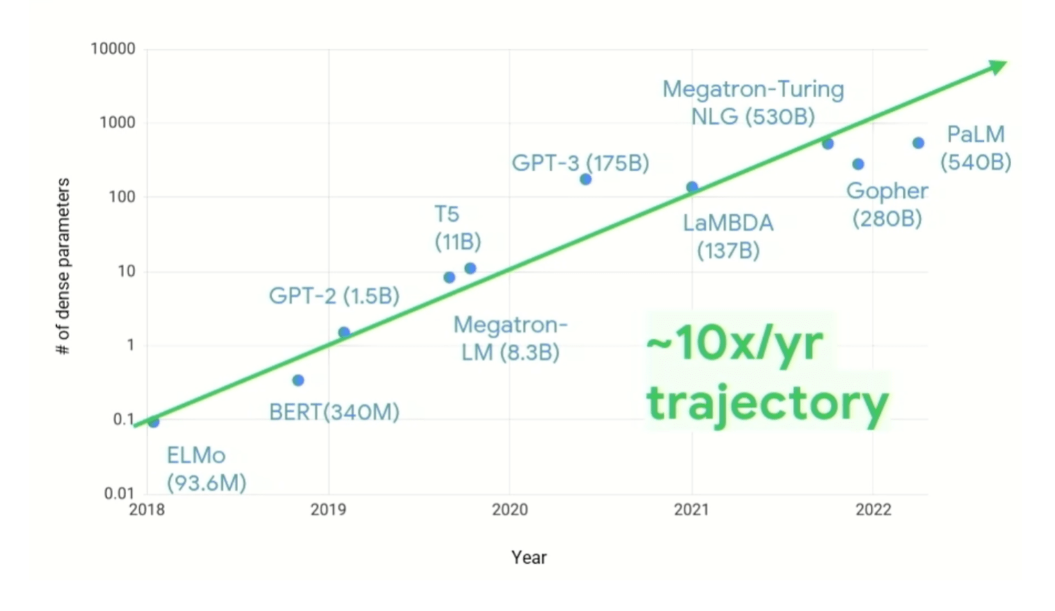

“我們需要改變對系統設計的看法,”Vahdat說。“過去五、六、七年中計算需求的增長令人震驚......雖然在[算法]稀疏性方面出現了許多創新,但當您查看[下面的圖 1]時,它顯示了 10 倍每個模型的參數數量持續一年。我們還知道,計算成本隨著參數數量的增加而超線性增長。因此,我們為應對這一挑戰而必須構建的計算基礎設施類型必須改變。值得注意的是,如果我們試圖在通用計算上做到這一點,我們就不會達到今天的水平。“

”我們在過去 50 或 60 年間開發的傳統計算智慧已被拋棄。”

芯片制造商正在利用演進和革命性技術,以相同或更低的功耗實現性能的數量級提高,這標志著從制造驅動設計到半導體架構師驅動設計的根本轉變。

然而,這并不意味著老問題消失了。功耗和散熱一直是設計團隊頭疼的問題,并且隨著處理速度和數量的增加,它們變得更加難以解決。在大約 3GHz 之后,由于熱密度更高且芯片無法散發熱量,僅僅調高時鐘頻率就不再是一個簡單的選擇。雖然稀疏數據模型和軟硬件協同設計解決了在各種處理元件上運行的軟件的效率,以及每個計算周期處理更多數據的能力,但不再需要轉動一個旋鈕來提高每瓦性能。

一、內存創新

然而,有許多小型和中型旋鈕,其中一些從未在生產系統中使用過,因為沒有經濟原因這樣做。隨著數據的增加和架構創新的轉變,這些經濟學發生了巨大的變化,這一點在今年的 Hot Chips 會議上顯而易見。

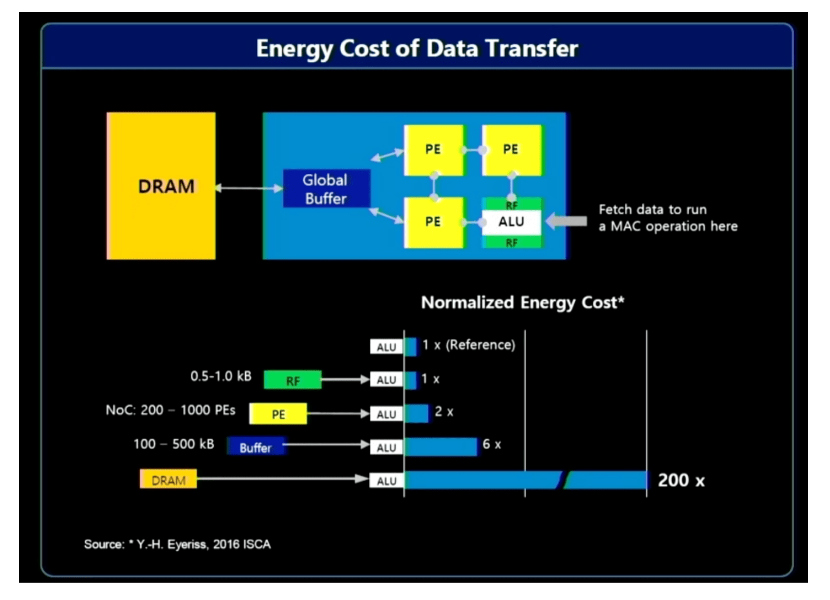

其中的選項包括內存中/近內存處理,以及更接近數據源的處理。這里的問題是,移動大量數據需要大量的系統資源——帶寬、電力和時間——這對計算有直接的經濟影響。一般來說,收集和處理的大部分數據都是無用的。例如,汽車或安全系統中的視頻輸入中的相關數據可能僅持續一兩秒,而可能需要數小時的數據進行整理。對靠近源頭的數據進行預處理,并使用人工智能來識別感興趣的數據,意味著只需發送一小部分數據進行進一步處理和存儲。

三星首席工程師 Jin Hyun Kim 表示:“大部分能源消耗來自移動數據。” 他指出了三種提高效率和提升績效的解決方案:

使用 HBM 進行內存處理,實現極高的帶寬和功耗;

使用 LPDDR 對需要高容量的低功耗設備進行內存處理

使用 CXL 進行近內存處理,以適中的成本實現極高的容量。

內存處理已經在繪圖板上醞釀了很多年,直到最近才出現太大進展。大型語言模型已經極大地改變了經濟學,現在它變得更加有趣,大型內存供應商也沒有忽視這一點。

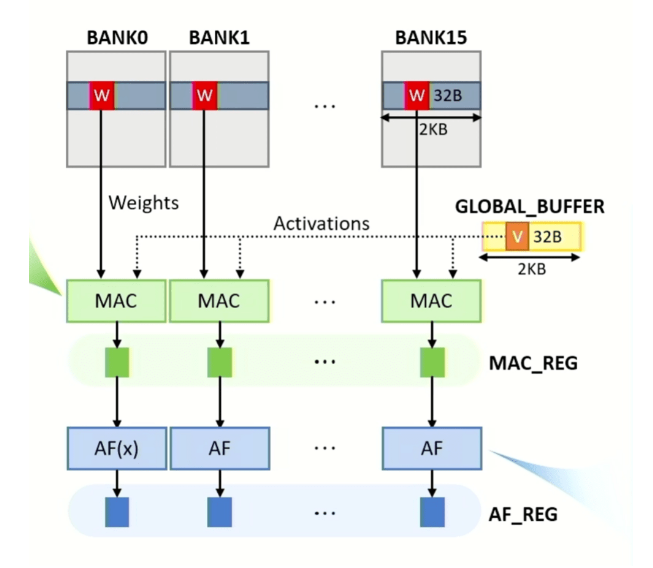

這一概念的新改進是內存加速,這對于 AI/ML 的乘法累加 (MAC) 函數特別有用,因為需要快速處理的數據量呈爆炸式增長。使用生成式預訓練 Transformer 3 (GPT-3) 和 GPT4,僅加載數據就需要大量帶寬。與此相關的挑戰有很多,包括如何有效地做到這一點,同時最大限度地提高性能和吞吐量,如何擴展它以處理大型語言模型中參數數量的快速增加,以及如何建立靈活性以適應未來的變化。

SK hynix America 高級技術傳感經理 Yonkwee Kwon 在 Hot Chips 2023 上的演講中表示:“我們一開始的想法是將內存作為加速器。”“第一個目標是實現高效擴展。但擁有高性能也很重要。最后,我們設計的系統架構易于編程,同時最大限度地減少系統結構開銷,但仍然允許軟件堆棧實現靈活性。

二、CPU 改進

雖然內存的變化有助于減少需要移動的數據量,但這只是難題的一小部分。下一個挑戰是加快主要處理元素的速度。做到這一點的一種方法是分支預測,它基本上預測下一個操作將是什么——幾乎就像互聯網搜索引擎的方式一樣。然而,與任何并行架構一樣,關鍵是保持各種處理元素充分運行,沒有空閑時間,以最大限度地提高性能和效率。

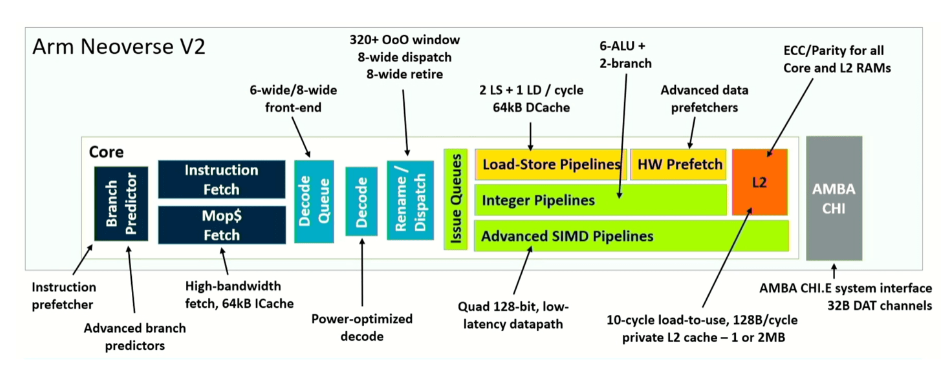

Arm 通過其 Neoverse V2 設計對這一概念進行了新的改造,將分支與獲取分離(decoupling branch from fetch)。其結果是通過最大限度地減少停頓來提高效率,并從錯誤預測中更快地恢復。Arm 首席 CPU 架構師 Magnus Bruce 表示:“動態饋送機制允許內核調節攻擊性,并主動防止系統擁塞。”“這些基本概念使我們能夠推動機器的寬度和深度,同時保持較短的管道以快速恢復錯誤預測。”

這里的不同之處在于,整個系統的改進來自于架構在多個點的調整,而不是大規模的改變。例如,拆分分支預測器和獲取可以將分支目標緩沖區拆分為兩個級別,使其能夠處理多 50% 的條目。它還將預測器中存儲的歷史記錄增加了三倍,并將獲取隊列中的條目數量增加了一倍,從而顯著提高了實際性能。為了使其有效,該架構還將 L2 緩存加倍,從而將使用過的數據塊預測和使用過的多次數據塊預測分開。綜合各種改進,Neoverse V2 的性能是 V1 的兩倍,具體取決于它在系統中扮演的角色。

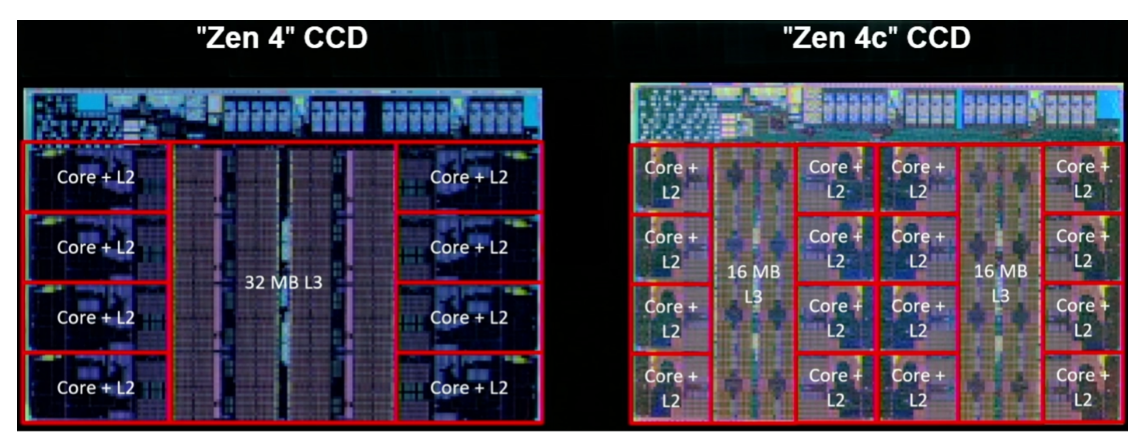

與此同時,AMD 的下一代 Zen 4 核心由于微架構的改進,每周期指令數增加了約 14%,由于工藝擴展,在相同電壓下 5nm 下的頻率提高了 16%,由于微架構和技術的改進,功耗降低了約 60%。物理設計改進。

與 Arm 一樣,AMD 也致力于改進分支預測和獲取。AMD 研究員兼 Zen 4 首席架構師 Kai Troester 表示,由于更多的分支、每個周期更多的分支預測以及允許更多條目和每個條目更多操作的更大操作緩存,分支預測準確性得到了提高。它還添加了 3D V 高速緩存,將每個內核的 L3 高速緩存提升至高達 96 MB,并在 256 位數據路徑上使用兩個連續周期提供對 512 位操作的支持。簡而言之,該設計增加了數據管道的大小,并盡可能縮短數據必須傳輸的距離。

三、平臺架構系統

另一個主要趨勢是不斷增加的領域專用性,這對開發適用于所有應用程序的通用處理器的舊模式造成了嚴重破壞。現在的挑戰是如何提供本質上的大規模定制,有兩種主要方法:通過硬件或可編程邏輯添加可編程性,以及開發可互換部件的平臺。

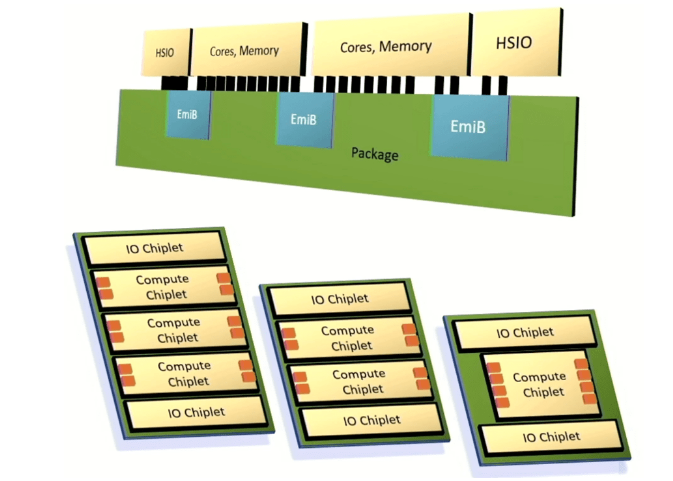

英特爾推出了一個將小芯片集成到先進封裝中的框架,該封裝利用其嵌入式多芯片互連橋來連接高速 I/O、處理器內核和內存。英特爾的目標是提供足夠的定制和性能來滿足客戶的需求,但交付這些系統的速度比完全定制的架構要快得多,并且結果可預測。

“這將是一個多芯片架構,”英特爾院士兼首席至強架構師 Chris Gianos 說道。“我們可以使用這些小芯片構建結構,具有很大的靈活性。它們都只是互操作,它為我們提供了專門優化產品核心的維度之一。我們將創建 E 核(超高效)的小芯片和 P 核(高性能)的小芯片。”

英特爾還創建了一個模塊化網狀結構來將各種組件連接在一起,以及一個支持 DDR 或 MCR 內存以及通過 CXL 連接的內存的通用控制器。

四、神經處理器、光學互連

即使對于 Hot Chips 會議來說,新方法和新技術的清單也是前所未有的。它表明業界正在多么廣泛地尋找增加功率和降低功率的新方法,同時仍然關注面積和成本。PPAC 仍然是焦點,但不同應用程序和用例的權衡可能非常不同。

IBM 研究員 Dharmendra Modha 表示:“人工智能的運營支出和資本支出正在變得不可持續。”他補充道,“架構勝過摩爾定律。”

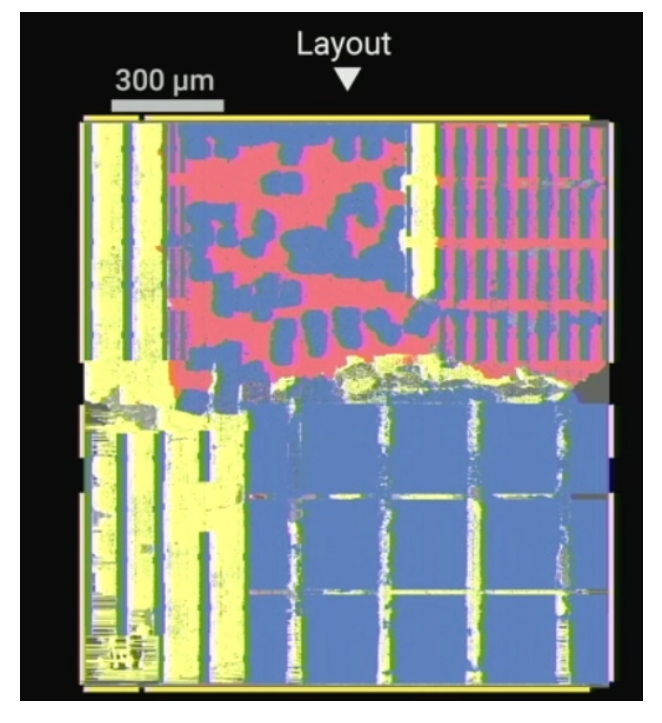

對于 AI/ML 應用來說,精度也至關重要。IBM 的設計包括一個支持混合精度的向量矩陣乘法器,以及具有 FP16 精度的向量計算單元和激活函數單元。此外,處理是在距離內存幾微米的范圍內完成的。“不存在依賴于數據的條件分支,”他說。“沒有緩存未命中、沒有停頓、沒有推測執行。”

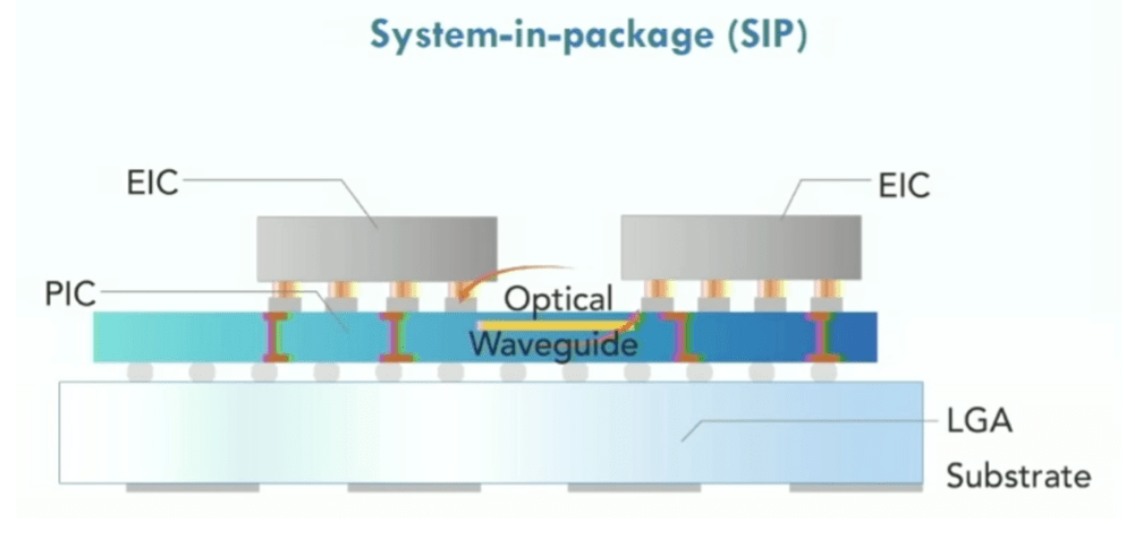

復雜芯片的一個關鍵挑戰不僅是在內存和處理器之間移動數據,而且還在于芯片周圍的數據移動。片上網絡和其他互連結構簡化了這一過程。硅光子學已經使用了一段時間,特別是對于高速網絡芯片,并且光子學在機架中的服務器之間發揮著作用。但是否或何時轉移到芯片層面仍不確定。盡管如此,這一領域的工作仍在繼續,根據芯片行業的大量采訪,光子學受到了許多公司的關注。

Lightelligence 工程副總裁 Maurice Steinman 表示,他的公司已經開發出專門構建的基于光子學的加速器,其速度比 GPU 快 100 倍,而且功耗顯著降低。該公司還開發了片上光學網絡,更多的是使用硅中介層作為使用光子而不是電子連接小芯片的介質。

“純電氣解決方案面臨的挑戰是,隨著距離的衰減,僅在最近的鄰居之間進行通信確實變得切實可行,”Steinman說。“如果[芯片]左上角有一個結果需要與右下角通信,那么它需要遍歷很多跳。這給負責分配資源的軟件組件帶來了問題,因為它需要考慮接下來的幾個棋步以避免擁塞。”

五、可持續性、可靠性和未來

隨著所有這些變化,另外兩個問題也出現了。一是可持續性。隨著更多的數據由更多的芯片處理,挑戰甚至將集中在能源消耗上,更不用說減少碳足跡了。更多更高效的設備并不一定會消耗更少的電力,而且制造所有這些設備都需要能源。

一段時間以來,數據中心一直是人們關注的目標。十年前,普遍認同的統計數據是數據中心消耗了地球上所有發電量的 2% 到 3%。美國能源效率和可再生能源辦公室表示,數據中心約占美國總用電量的 2%。這些數字并不總是準確的,因為綠色能源有多種,制造和回收太陽能電池板和風車葉片也需要能源。但很明顯,消耗的能源量將隨著數據的增長而繼續增長,即使它沒有以相同的速度跟蹤。

Hot Chips 以及其他會議上的許多演講都將可持續發展作為目標。盡管基礎數據可能有所不同,但事實上,這是許多芯片制造商的企業強制要求,這一點意義重大。

第二個尚未解決的問題是可靠性。許多新芯片設計也比前幾代芯片復雜幾個數量級。過去,主要問題是基板上可以塞滿多少晶體管以及如何避免芯片熔化。如今,數據路徑和分區如此之多,散熱只是眾多因素之一。隨著越來越多的數據被分區、處理、重新聚合和分析,結果的準確性和一致性可能更難以確定和保證,特別是當設備老化程度不同并以意想不到的方式交互時。

此外,谷歌研究院高級研究員兼高級副總裁 Jeff Dean 表示,模型正在從單一模態轉變為多種模態(圖像、文本、聲音和視頻),從密集模型轉向稀疏模型。“動力、可持續性和可靠性確實很重要,”他說,并指出許多有關人工智能訓練和 CO 2排放的數據都具有誤導性。“如果你使用正確的數據,事情并沒有那么可怕。”

六、芯片封裝清洗:

合明科技研發的水基清洗劑配合合適的清洗工藝能為芯片封裝前提供潔凈的界面條件。

水基清洗的工藝和設備配置選擇對清洗精密器件尤其重要,一旦選定,就會作為一個長期的使用和運行方式。水基清洗劑必須滿足清洗、漂洗、干燥的全工藝流程。

污染物有多種,可歸納為離子型和非離子型兩大類。離子型污染物接觸到環境中的濕氣,通電后發生電化學遷移,形成樹枝狀結構體,造成低電阻通路,破壞了電路板功能。非離子型污染物可穿透PC B 的絕緣層,在PCB板表層下生長枝晶。除了離子型和非離子型污染物,還有粒狀污染物,例如焊料球、焊料槽內的浮點、灰塵、塵埃等,這些污染物會導致焊點質量降低、焊接時焊點拉尖、產生氣孔、短路等等多種不良現象。

這么多污染物,到底哪些才是最備受關注的呢?助焊劑或錫膏普遍應用于回流焊和波峰焊工藝中,它們主要由溶劑、潤濕劑、樹脂、緩蝕劑和活化劑等多種成分,焊后必然存在熱改性生成物,這些物質在所有污染物中的占據主導,從產品失效情況來而言,焊后殘余物是影響產品質量最主要的影響因素,離子型殘留物易引起電遷移使絕緣電阻下降,松香樹脂殘留物易吸附灰塵或雜質引發接觸電阻增大,嚴重者導致開路失效,因此焊后必須進行嚴格的清洗,才能保障電路板的質量。

合明科技運用自身原創的產品技術,滿足芯片封裝工藝制程清洗的高難度技術要求,打破國外廠商在行業中的壟斷地位,為芯片封裝材料全面國產自主提供強有力的支持。

推薦使用合明科技水基清洗劑產品。

上一篇:華為Mate60 Pro的發售是否意味著華為芯片···

下一篇:助焊劑的工作原理

![[x]](/template/default/picture/closeimgfz1.svg)